FZ26000 wrote:Fender wrote:DanBa wrote:

Dolby Vision for Ultra HD Blu-ray

includes a 100% compatible HDR 10-bit video stream playable in all Ultra HD Blu-ray format players. An

Ultra HD Blu-ray title with Dolby Vision, when played in a Dolby Vision enabled player and connected to a Dolby Vision enabled display,

yields a 12-bit video quality image with an expanded dynamic range and remarkable color depth, along with dynamic metadata to ensure an accurate presentation of the creative intent approved by the film maker. Combined with Ultra HD Blu-ray’s massive data rate, Dolby Vision titles will deliver an unsurpassed home entertainment experience."[/i]

http://www.businesswire.com/news/home/2 ... n-Ultra-HD

les BD-UHD Dolby Vision auront 2 flux vidéo séparés ? ou y'a une encapsulation d'une sorte de conteneur qui permet d'avoir le flux principal 10-bit et un flux auxilliaire avec les infos en plus ?

mes souvenirs de fonctions de transfert sont loin, du coup, je comprends pas bien le fonctionnement de ce flux qui transformerait un flux 10-bit en flux 12-bit...

... j'ai lu et relu, et c'est pas très clair pour le profane que je suis, dans ce domaine ...

... perso je pense plutôt que c'est le flux 12 bits qui est transformé en 10 bits (car qui peut le plus, peut le moins ...) quant un appareil non compatible Dolby Vision HDR est détecté ...

Par ailleurs (corrigez moi si je dis des conneries ...) euh ... des dalles 12 bits, y'en a pas (encore) non ...? :sweat:

Dolby Vision dispose d’une architecture à 2 couches : couche de base (base layer) et couche additionnelle (enhancement layer).

La couche de base peut être du SDR 8 bits / gamut Rec.709 / 100 nits ou du HDR10 10 bits / gamut containeur Rec.2020 / jusqu’à 10.000 nits (i.e. fonction de transfert PQ SMPTE ST2084 EOTF) ou autre.

Pour le standard UHD Blu-ray, la couche de base de Dolby Vision est du HDR10.

[On va dire SDR = HDR10 momentanément et EDR = VDR = Dolby Vision pour mieux suivre les diagrammes et le brevet Dolby sur le sujet].

https://www.smpte.org/sites/default/fil ... system.pdf

http://www.google.ch/patents/US20140050271

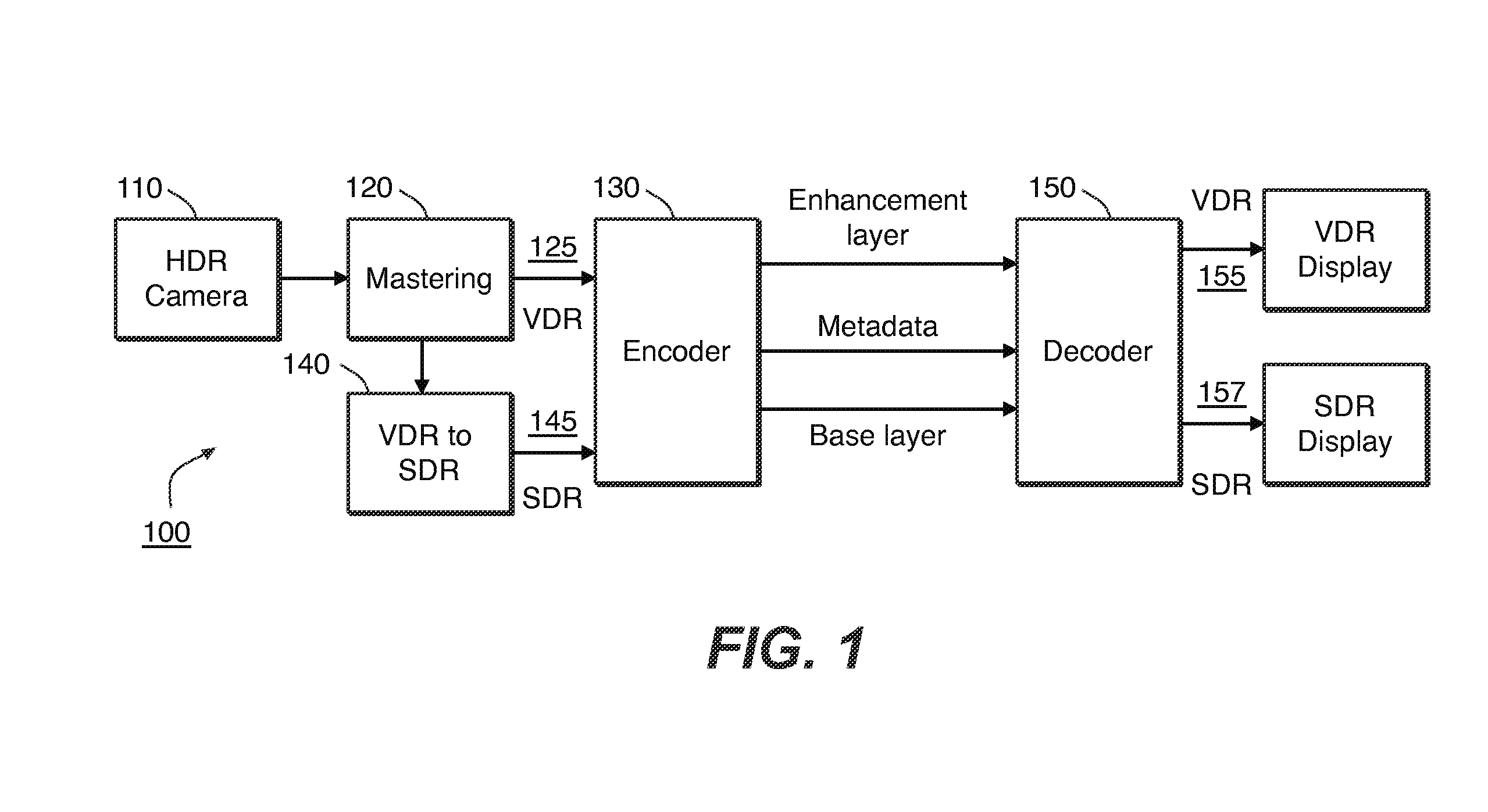

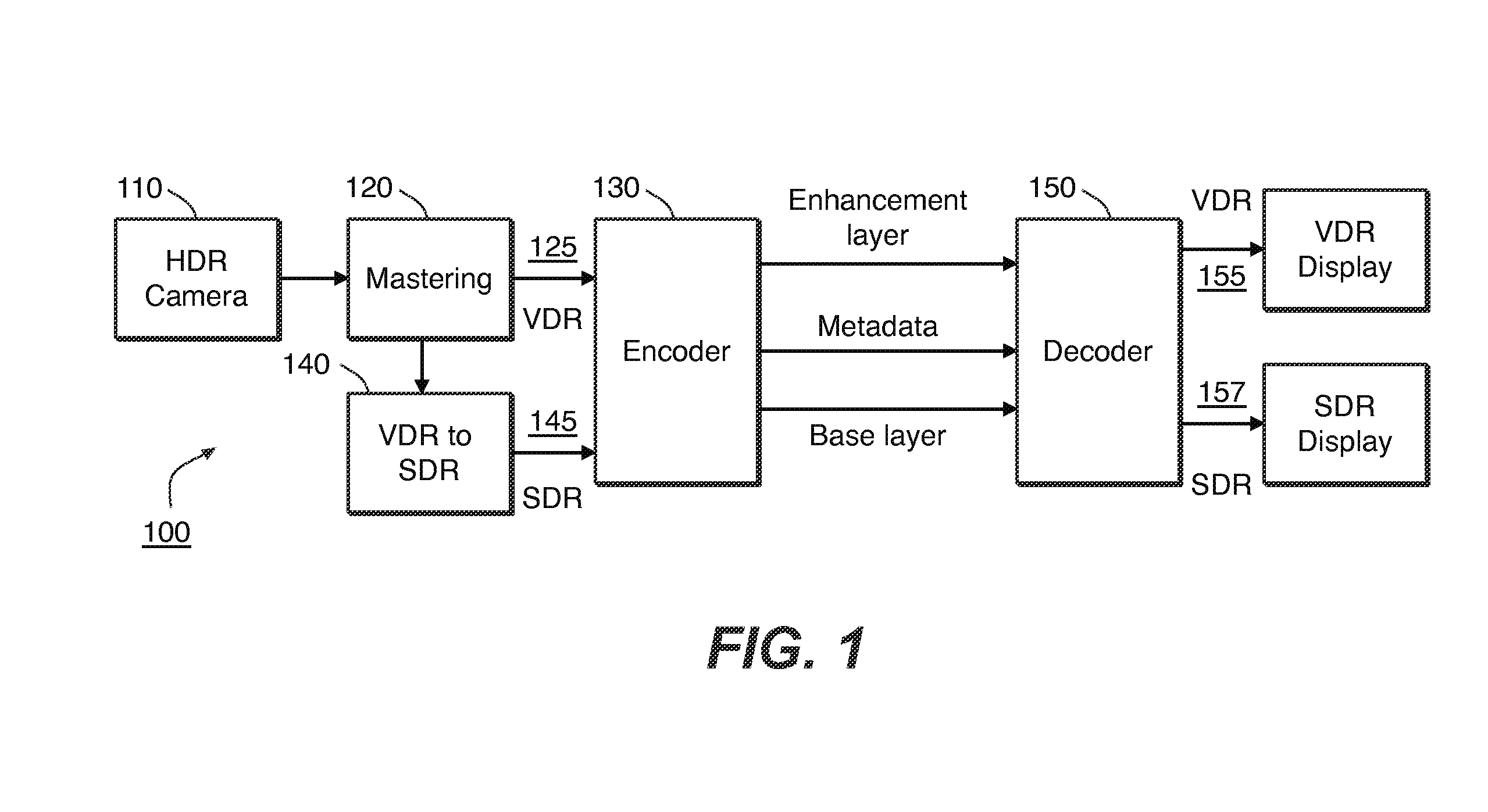

A partir des images captées par une caméra HDR 110, le film est créé à la post-production 120.

A l'issue du mastering à la post-production, on a un master VDR 125 de 12 bits, un master SDR 145 de 10 bits et des metadata.

Tout en utilisant des encodeurs existants normalisés (HEVC 10 bits notamment), l’encodage crée :

. un flot de signal vidéo Base layer SDR et

. un flot de signal vidéo Enhancement Layer grâce à un système de soustraction VDR – SDR

. un flot de metadata.

Tout en utilisant des décodeurs existants normalisés (HEVC 10 bits notamment), à la sortie de la phase de décodage, on a :

. un flot de signal vidéo Base layer SDR / HDR10 de 10 bits à envoyer vers un TV SDR / HDR10, et aussi les metadata statiques HDR10 qui requièrent leur transfert vers un TV HDR10 par une interface HDMI 2.0a

. un flot de signal vidéo Dolby Vision VDR de 12 bits, à envoyer vers un TV Dolby Vision, qui résulte de la combinaison des signaux vidéo Base layer + Enhancement Layer + metadata.

Comme les metadata Dolby Vision sont incorporées dans le flot Dolby Vision VDR, elles n’ont pas besoin d’utiliser le mécanisme de transfert de metadata statiques de HDMI 2.0a, ni du futur mécanisme de transfert de metadata dynamiques de HDMI 2.1.

Grâce à son architecture astucieuse à 2 couches, Dolby Vision est dans le nouveau monde des 10 bits et aussi dans le futur monde des 12 bits.

Un bon standard doit perdurer durant de nombreuses années. Les entités de post-production de films encodés en Dolby Vision utilisent des moniteurs de 12 bits.

Comme le flux de signal vidéo HDR10 de 10 bits peut être exploité par des TV HDR10 à dalle de 8 bits,

http://www.avsforum.com/forum/465-high- ... depth.html

un flux de signal vidéo Dolby Vision de 12 bits peut être exploité par des TV à dalle de 10 bits.

Normalement, toute autre chose étant égale (même technologie de dalle, même traitement vidéo …)

Dolby Vision 12 bits sur dalle 10 bits < Dolby Vision 12 bits sur dalle 10 bits + dithering < Dolby Vision 12 bits sur dalle 12 bits

Selon Matt McRae, CTO de Vizio, beaucoup de TV à dalle de 10 bits ne disposent que de driver IC de conversion numérique-analogique de 8 bits ! Les 2 bits d’origine perdus au niveau du driver IC sont perdus pour toujours ; ils sont artificiellement recréés par la suite pour l’affichage.

"Many companies claim 10bit... and maybe a part of their system is 10bit like the panel, but it turns out their driver ICs are 8bit or there PQ processing engines have a section in the video pipeline that is 8 bit. That is not 8bit because once you drop the signal you lose the information and never get it back.

When VIZIO claims 10bit it means that EVERY step in the video pipeline and hardware is 10bit OR MORE... was extremely difficult on Reference Series because we set out to do first true 10bit TV and it turned out we had to wait for 10bit driver ICs to be invented (they didn't exist yet even though other brands were claiming 10bit TVs in the market  "

http://www.avsforum.com/forum/166-lcd-f ... st42702618

"

http://www.avsforum.com/forum/166-lcd-f ... st42702618